L’intelligence artificielle et l’éducation publique

Réglementer l’utilisation de l’IA dans l’éducation publique au Canada, de la maternelle à la 12e année

Les différents paliers de gouvernement doivent réglementer de toute urgence l’utilisation de l’IA dans les écoles publiques canadiennes, de la maternelle à la 12e année.

L’intégration de l’IA dans l’éducation soulève des préoccupations d’ordre éthique, pédagogique et pratique qui requièrent une approche responsable et une réglementation rigoureuse. Les enseignantes et enseignants utilisent l’IA pour rehausser l’expérience d’apprentissage de leurs élèves en n’ayant que peu de directives et de mesures de protection, ce qui crée des risques de violation des données, de biais algorithmiques et d’affaiblissement des normes professionnelles de l’enseignement.

La CTF/FCE est déterminée à faire en sorte que l’utilisation de l’IA dans le milieu de l’éducation publique soit bénéfique tant pour les élèves que le personnel enseignant. L’IA doit soutenir — et non pas remplacer — l’aspect humain dans le cadre pédagogique actuel.

Pour passer à l’action : découvrez les ressources ci-dessous pour vous renseigner et faire passer le mot.

Pour un encadrement rigoureux de l’IA dans l’éducation publique

Le Canada se doit d’adopter, pour le secteur de l’éducation publique, de la maternelle à la 12e année, un vaste cadre de gouvernance sur l’IA qui favorise l’équité, la transparence et la reddition de comptes.

Que ce soit à l’échelon fédéral ou provincial/territorial, le pays ne dispose pas à l’heure actuelle de balises claires pour garantir une utilisation sécuritaire, éthique et équitable des systèmes d’IA dans les écoles. Si rien n’est fait rapidement, les enseignantes et enseignants continueront à porter sur leurs épaules la responsabilité des répercussions que peut avoir l’IA sur les élèves sans bénéficier de protection ni de garde-fou.

La législation fédérale

La Loi sur l’intelligence artificielle et les données (LIAD) a été proposée dans le cadre du projet de loi C-27 présenté au cours de la 44e législature canadienne. Si la LIAD traite de la protection des données de manière générale, elle ne comprend pas de disposition précise pour contrer les risques particuliers que présente l’utilisation de l’IA dans le secteur de l’éducation, notamment pour les élèves d’âge mineur.

La dissolution de la 44e législature le 23 mars 2025 a tué dans l’œuf le projet de loi, qui devra faire l’objet d’un nouveau dépôt lors de la prochaine session parlementaire.

Les appels à l’action de la CTF/FCE

La CTF/FCE demande au gouvernement fédéral et au Conseil des ministres de l’Éducation (Canada) [CMEC] de travailler avec les provinces et les territoires pour instaurer un cadre réglementaire contraignant qui :

- protège les renseignements personnels et les données des élèves;

- régit le recours à l’IA en classe;

- favorise une utilisation responsable et éthique des systèmes d’IA dans l’éducation publique.

Ensemble, nous pouvons construire un avenir où la technologie est au service de l’éducation.

Définir la place de l’IA dans le secteur de l’éducation publique canadien

Les écoles détiennent de vastes quantités de données sensibles, mais la plupart ne disposent pas d’infrastructure pour se prémunir des cybermenaces. Les craintes au sujet de la confidentialité et de la sécurité des données sont exacerbées par le fait que les outils de l’IA et de l’IA générative sont de plus en plus répandus en milieu scolaire.

Intelligence artificielle renvoie à « […] un système automatisé qui, pour un ensemble donné d’objectifs définis par l’homme, est en mesure d’établir des prévisions, de formuler des recommandations ou de prendre des décisions influant sur des environnements réels ou virtuels ». (UNICEF, 2021, p. 16)

Intelligence artificielle générative renvoie à une IA « […] qui génère automatiquement du contenu en réponse à des messages rédigés dans des interfaces de conversation en langage naturel. […] Elle génère son contenu en analysant, à l’aide de statistiques, la distribution des mots, des pixels ou d’autres éléments dans les données qu’elle a ingérées et en identifiant et répétant des modèles communs ». (UNESCO, 2023, p. 8)

Cyberattaque chez PowerSchool : Un cas édifiant

En décembre 2024, PowerSchool, un fournisseur de premier plan de services éducationnels basés sur l’infonuagique, a été victime d’une importante cyberattaque qui a porté atteinte à l’intégrité des données personnelles d’élèves et de membres du personnel de l’enseignement au Canada et aux États-Unis.

Les pirates informatiques, qui sont parvenus à s’infiltrer dans le système de renseignements sur les élèves en passant par le portail de service à la clientèle de PowerSource, ont eu accès à des données sensibles comme des noms, des coordonnées, des dates de naissance, des dossiers médicaux et, dans certains cas, des numéros d’assurance sociale (TechTarget, 2025 — en anglais seulement).

Au Canada, 76 % des élèves utilisent les produits de PowerSchool. Cette fuite de données a touché plus de 80 conseils scolaires dans sept provinces et un territoire. Le conseil scolaire anglophone du district de Toronto a confirmé que la sécurité des données d’environ 1,5 million d’élèves avait ainsi été compromise.

L’attaque perpétrée contre PowerSchool illustre bien l’urgence de doter le système d’éducation canadien, de la maternelle à la 12e année, de solides mesures en matière de cybersécurité.

Principales conclusions de la recherche

Opinion publique

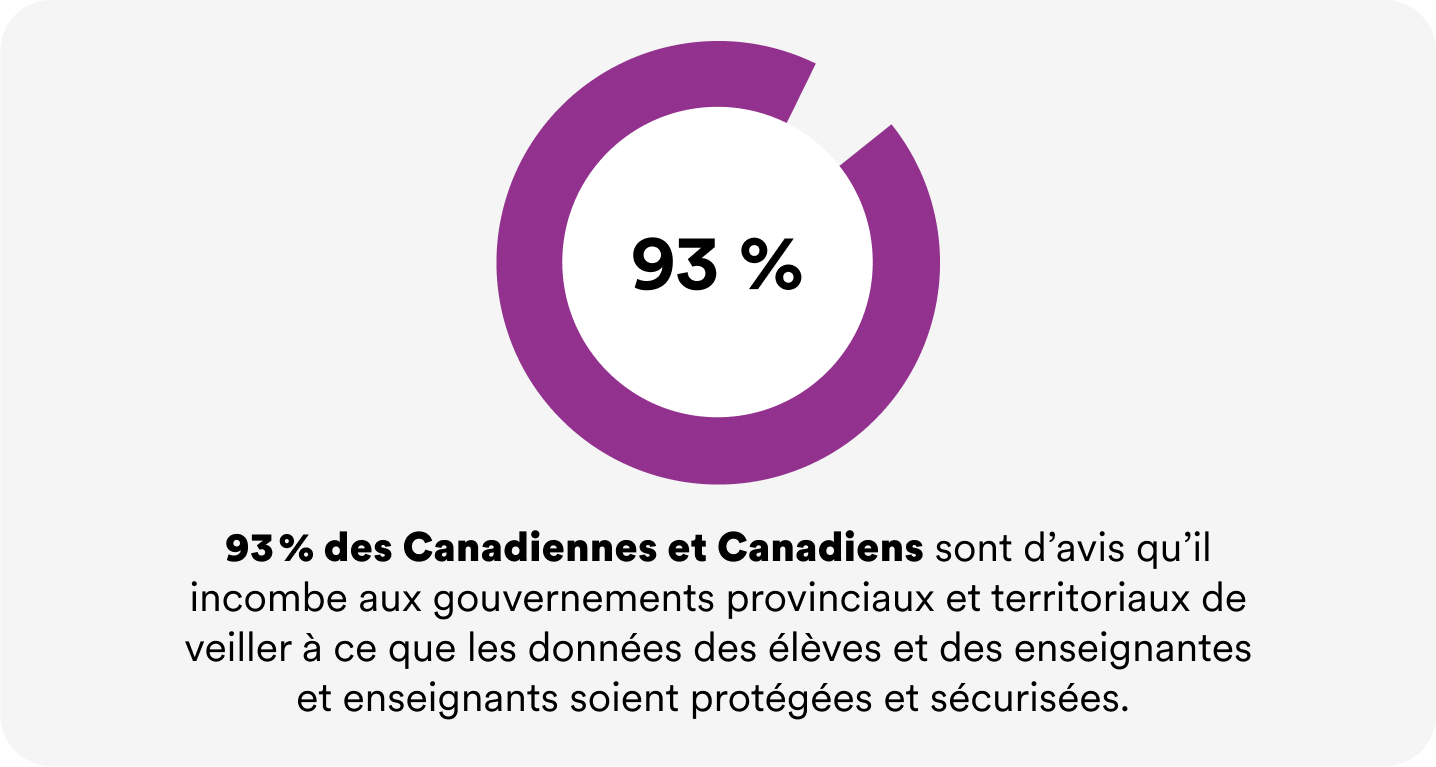

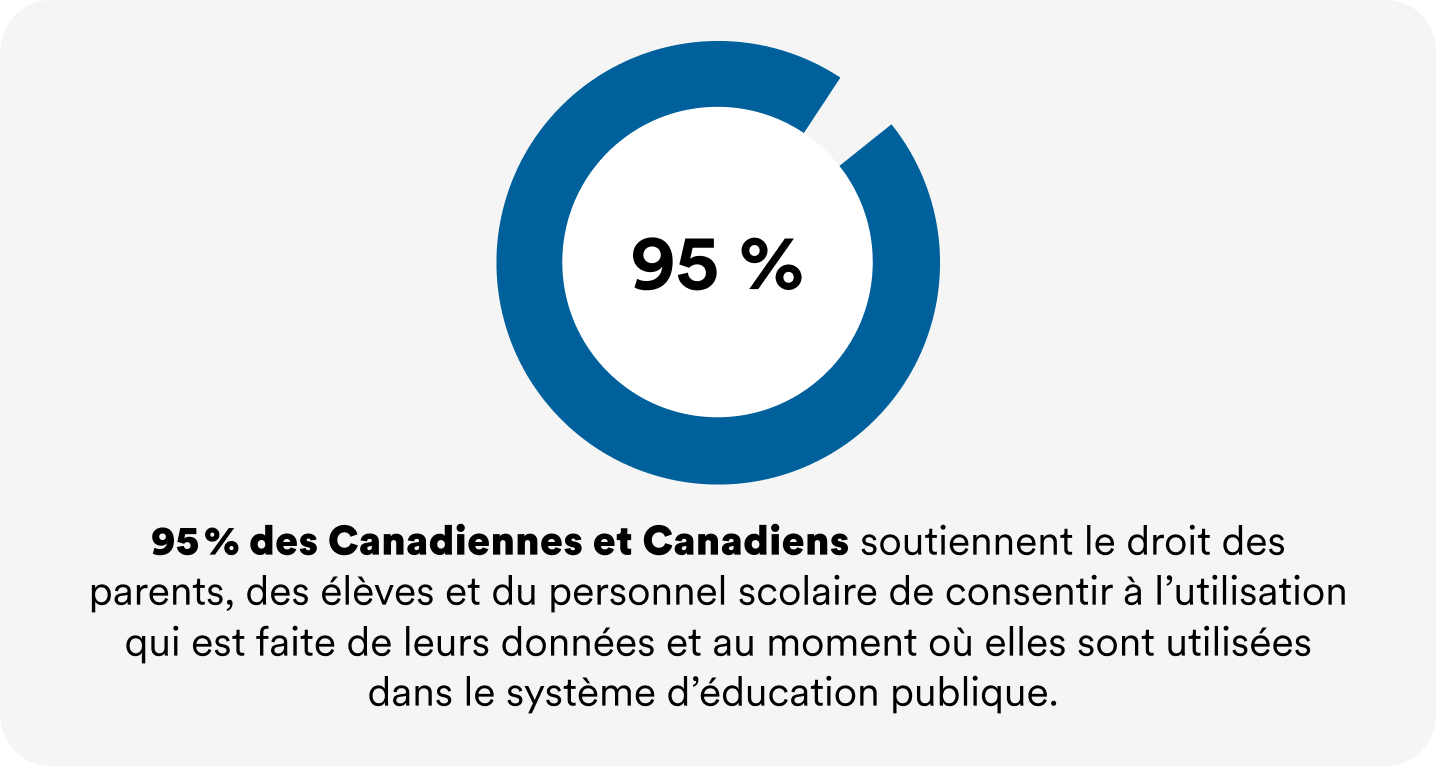

Un sondage d’opinion publique national mené par Abacus Data au nom de la CTF/FCE en 2024 a révélé ce qui suit :

- 95 % des Canadiennes et Canadiens soutiennent le droit des parents, des élèves et du personnel scolaire de consentir à l’utilisation qui est faite de leurs données et au moment où elles sont utilisées dans le système d’éducation publique.

- 93 % des Canadiennes et Canadiens sont d’avis qu’il incombe aux gouvernements provinciaux et territoriaux de veiller à ce que les données des élèves et des enseignantes et enseignants soient protégées et sécurisées.

Enquêtes

- Une enquête réalisée par l’UNESCO en 2023 a révélé que moins de 10 % des écoles dans le monde avaient des politiques sur l’utilisation de l’IA.

- D’après des données de KPMG datant de 2023, plus de la moitié des étudiantes et étudiants du Canada âgés de plus de 18 ans se servent de l’IA pour leurs travaux ou examens.

Recommandations

Mode de gouvernance à plusieurs niveaux

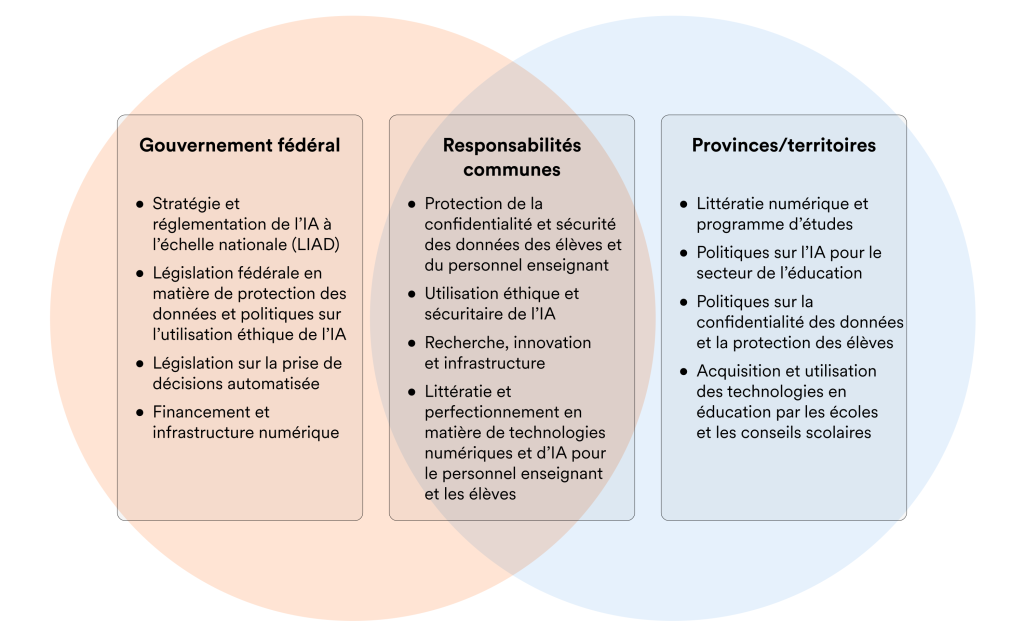

Si les gouvernements provinciaux et territoriaux ont un rôle crucial à jouer dans la réglementation de l’IA — en particulier dans leur domaine de compétence qu’est l’éducation — la plupart ne se sont pas dotés de cadres ni de politiques globales en matière d’IA pour en assurer une intégration éthique et responsable. Jusqu’à présent, seules les provinces de l’Ontario, du Québec, de l’Alberta et de la Colombie-Britannique disposent d’un cadre ou de lignes directrices sur l’IA.

Pour creuser le sujet plus en profondeur, veuillez consulter le résumé de l’analyse des textes législatifs et des politiques traitant de l’intelligence artificielle intitulé Résumé de l’analyse des textes législatifs et des politiques traitant de l’IA.

Il est essentiel d’adopter un mode de gouvernance à plusieurs niveaux pour que l’IA soit au service de l’éducation publique :

Gouvernement du Canada

- Réglementer à l’échelle nationale les stratégies en matière d’IA, de confidentialité et de protection des données.

- Adopter des mesures pour réglementer l’intégration de l’IA en éducation sans perdre de vue la nécessité de doter le pays de dispositifs plus rigoureux en matière de protection des renseignements personnels, de transparence et de reddition de comptes. Exemple : amender le projet de Loi sur l’intelligence artificielle et les données pour y ajouter des dispositions concernant l’éducation et les systèmes d’IA à incidence élevée.

Gouvernements provinciaux et territoriaux

- Superviser des domaines clés comme l’élaboration de programmes d’études spécifiques à l’IA, l’intégration en classe et la formation des enseignantes et enseignants;

- Collaborer avec les conseils scolaires (et leurs équivalents), les syndicats, les écoles et les enseignantes et enseignants pour que le personnel de l’éducation bénéficie de mesures de protection concertées et de directives sur l’IA.

Conseils scolaires (et leurs équivalents)

- Instaurer un cadre réglementaire en consultation avec les provinces et les territoires pour :

- veiller à ce que l’acquisition et l’utilisation de logiciels d’IA se fassent dans le respect des normes éthiques et pédagogiques;

- avoir des mécanismes de protection des renseignements personnels qui assurent la sécurité des données des élèves et du personnel enseignant;

- garantir un accès équitable aux technologies de l’IA pour éviter d’entraîner de nouvelles disparités dans le secteur de l’éducation.

Mode de gouvernance à plusieurs niveaux

Sans une action concertée, des mesures stratégiques proactives et un dispositif clair de reddition de comptes, les établissements d’enseignement resteront exposés aux cybermenaces. Les pouvoirs publics à tous les échelons doivent agir dès à présent pour mettre en place des politiques qui protègent les droits du personnel enseignant et des élèves.

Ressources

Épisode du balado Source

Dans cet épisode de Source, Christina J. Colclough, Ph. D., fondatrice du Why Not Lab et défenseuse des droits numériques des travailleurs et travailleuses, parle de l’incidence des technologies numériques de l’IA sur le personnel de l’éducation. Écoutez l’épisode pour en savoir plus sur la protection des droits des travailleurs et travailleuses et la confidentialité, les outils qui peuvent soutenir les négociations collectives en ce qui concerne les technologies numériques, et les actions politiques en faveur des droits numériques.

(Balado en anglais, accompagné d’un document en français présentant les faits saillants)

Lignes directrices sur l’IA en l’absence de législation

Pour pallier l’absence de législation sur l’IA, divers organes du monde de l’éducation ont élaboré des lignes directrices pour promouvoir une utilisation responsable de l’IA dans les écoles, notamment :

- les gouvernements de la Colombie-Britannique, du Nouveau-Brunswick (en anglais seulement), du Québec (par l’intermédiaire du Conseil supérieur de l’éducation et de la Commission de l’éthique en science et en technologie);

- des conseils scolaires tels que le l’Ottawa Catholic School Board, le Waterloo Catholic District School Board, le Holy Trinity Catholic School Division, la Lloydminster Public School Division (pages Web en anglais seulement);

- L’AEFO.

Ces lignes directrices visent à protéger les renseignements personnels des élèves, à garantir une utilisation éthique de l’IA et à répondre aux préoccupations sur la santé et la sécurité des élèves et du personnel enseignant. Elles ont toutefois tendance à attribuer une grande part de responsabilité aux enseignantes et enseignants, qui doivent comprendre le fonctionnement des outils de l’IA, protéger la confidentialité des données de leurs élèves, s’en remettre à leur seul jugement et encourager les élèves à utiliser l’IA de manière éthique. Cela illustre bien la nécessité d’une action urgente de la part de tous les paliers de gouvernement.

Nous vous invitons à consulter ces ressources complémentaires.